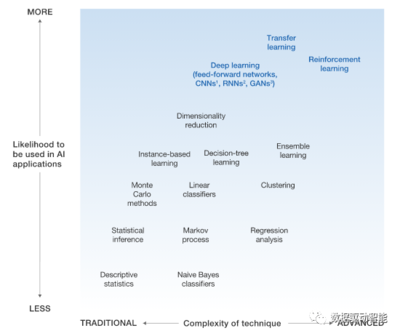

隨著人工智能的迅猛發展,深度學習作為核心技術之一,已在圖像識別、自然語言處理等領域取得顯著成果。其廣泛應用仍面臨若干關鍵問題。同時,網絡技術的研究為這些問題的解決提供了重要支撐。本文將結合網絡技術探討深度學習的四個核心問題。

數據依賴與質量問題是深度學習的首要挑戰。深度學習模型通常需要大量標注數據進行訓練,而數據的獲取與標注成本高昂。數據質量直接影響模型性能,噪聲數據或不平衡數據集可能導致模型偏差。在網絡技術研究中,分布式數據采集與邊緣計算技術能夠幫助高效收集與預處理數據,而聯邦學習等隱私保護技術則可在不集中數據的前提下進行模型訓練,緩解數據孤島問題。

模型可解釋性不足制約了深度學習的可信應用。許多深度學習模型如黑盒一般,決策過程難以理解,這在醫療、金融等高風險領域尤為關鍵。網絡技術的研究通過可視化工具和在線分析平臺,促進了模型內部機制的探索。例如,基于云端的交互式系統允許研究人員實時監控和解釋模型行為,結合圖神經網絡(GNN)等技術,提升了對復雜數據關系的理解。

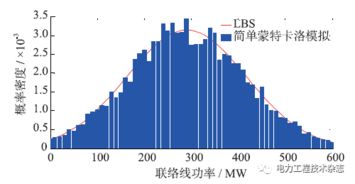

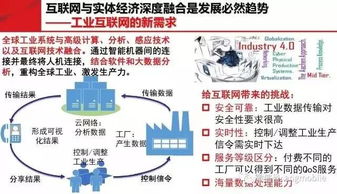

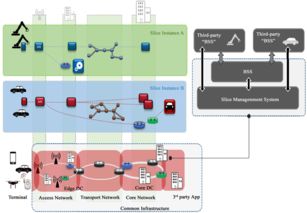

第三,計算資源需求巨大是深度學習的另一瓶頸。訓練深度模型需要高性能硬件,如GPU集群,導致成本高昂且能耗大。網絡技術在此方面發揮了關鍵作用,通過云計算和分布式計算框架(如TensorFlow和PyTorch的分布式版本),實現了資源的彈性調度與共享。軟件定義網絡(SDN)和5G技術進一步優化了數據傳輸效率,支持大規模模型在邊緣設備與云端協同訓練,降低了延遲與帶寬壓力。

泛化能力與魯棒性問題限制了深度學習的實際部署。模型在訓練數據上表現優異,但面對未知環境或對抗性攻擊時可能失效。網絡技術的研究通過構建模擬環境和實時測試平臺,幫助評估模型魯棒性。例如,利用虛擬網絡和仿真工具,可以生成多樣化的測試場景,而自適應網絡協議則能確保模型在動態網絡條件下保持穩定性能。區塊鏈技術被探索用于記錄模型版本與數據溯源,增強系統的可靠性與安全性。

深度學習的四個問題——數據依賴、可解釋性、資源需求和泛化能力——在本質上是相互關聯的,而網絡技術的研究為解決這些問題提供了創新途徑。未來,隨著邊緣計算、6G網絡和量子計算等技術的發展,深度學習有望在更廣泛的領域實現突破,推動人工智能的可持續發展。研究者應加強跨學科合作,將網絡技術與深度學習深度融合,以應對日益復雜的應用需求。